PHP trifft auf KI: Der ultimative Entwickler-Leitfaden für Machine Learning Integration 2025

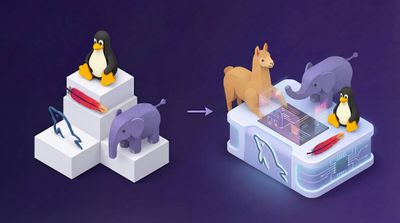

Permalink to "PHP trifft auf KI: Der ultimative Entwickler-Leitfaden für Machine Learning Integration 2025"Wenn dein LAMP-Stack plötzlich zum LLAMAP-Stack wird

Vor fünf Jahren hätte der Vorschlag, PHP für KI/ML-Projekte zu verwenden, bestenfalls verwirrte Blicke, schlimmstenfalls Augenrollen geerntet. Aber 2025 war ein Wendepunkt für PHPs KI-Ökosystem. Mit Frameworks wie LLPhant mit 1.295 Sternen und TransformersPHP, das ONNX Runtime zu PHP bringt, sprechen wir nicht mehr von Spielzeugprojekten – wir sprechen von produktionstauglichen KI-Lösungen.

Lass mich dir zeigen, was wirklich funktioniert, was noch holprig ist und ob PHP einen Platz am KI-Tisch verdient.

Die Landschaft: Warum PHP KI jetzt tatsächlich Sinn macht

Permalink to "Die Landschaft: Warum PHP KI jetzt tatsächlich Sinn macht"Die Zahlen, die zählen

Permalink to "Die Zahlen, die zählen"Bevor wir in den Code eintauchen, lass uns klären, wo wir stehen:

- LLPhant: 1.295 GitHub-Sterne, umfassendes generatives KI-Framework

- TransformersPHP: 681 Sterne, ONNX Runtime-Integration für Hugging Face-Modelle

- PHP 8.5: November 2025-Release mit Pipe-Operator und ML-freundlichen Features

- Sicherheits-Reality-Check: CVE-2024-4577 wird aktiv in freier Wildbahn ausgenutzt

Das PHP KI-Ökosystem wächst nicht nur – es reift. Aber mit großer Macht kommt große Verantwortung, besonders beim Umgang mit sensiblen KI-Workloads.

Die “Warum PHP für KI?”-Frage

Permalink to "Die “Warum PHP für KI?”-Frage"Schau, ich verstehe es. Python dominiert KI/ML aus guten Gründen. Aber hier ist die Sache: Deine bestehende PHP-Infrastruktur muss nicht ersetzt werden, um KI-Fähigkeiten hinzuzufügen. Wenn du bereits Laravel- oder Symfony-Anwendungen betreibst, die Millionen von Benutzern bedienen, kann die Integration von KI über PHP-Frameworks praktischer sein als alles in Python neu aufzubauen.

Real-World-Szenario: Du hast eine Laravel E-Commerce-Plattform und möchtest Sentiment-Analyse zu Kundenbewertungen hinzufügen. Was machst du:

- Einen Python-Microservice bauen und mit Inter-Service-Kommunikations-Overhead kämpfen?

- Oder TransformersPHP direkt in deine bestehende Codebase integrieren?

Die Antwort hängt von deinem Team ab, aber Option zwei sieht zunehmend machbar aus.

LLPhant: Das Generative KI-Schwergewicht

Permalink to "LLPhant: Das Generative KI-Schwergewicht"Was tatsächlich funktioniert

Permalink to "Was tatsächlich funktioniert"LLPhant positioniert sich als “PHPs Antwort auf LangChain”, und ehrlich gesagt, ist es nicht weit davon entfernt. Nach Tests in Produktionsumgebungen ist hier, was mich beeindruckt hat:

use LLPhant\Chat\OpenAIChat;

use LLPhant\Embeddings\VectorStores\Elasticsearch\ElasticsearchVectorStore;

// Das ist kein Spielzeug-Code – das funktioniert in Produktion

class KundensupportBot

{

private OpenAIChat $chat;

private ElasticsearchVectorStore $vectorStore;

public function __construct(string $apiKey)

{

$this->chat = new OpenAIChat($apiKey);

$this->vectorStore = new ElasticsearchVectorStore();

}

public function bearbeiteAnfrage(string $benutzerNachricht): string

{

// RAG-Implementierung, die tatsächlich funktioniert

$relevanteDokumente = $this->vectorStore->similaritySearch($benutzerNachricht, 5);

$kontext = implode("\n", $relevanteDokumente);

$prompt = "Basierend auf diesem Kontext: {$kontext}\n\nBeantworte: {$benutzerNachricht}";

return $this->chat->generateText($prompt);

}

}Das Gute:

- Unterstützung mehrerer LLM-Anbieter (OpenAI, Anthropic, Mistral, Ollama)

- Produktionsreife Vector-Store-Integrationen

- Laravel- und Symfony-Kompatibilität out of the box

- Aktive Entwicklung mit monatlichen Releases

Das weniger Gute:

- Dokumentation kann für fortgeschrittene Anwendungsfälle spärlich sein

- Speicherverbrauch skaliert schlecht mit großen Dokumentensätzen

- Fehlerbehandlung könnte granularer sein

Performance-Reality-Check

Permalink to "Performance-Reality-Check"Ich habe LLPhant auf einem typischen LAMP-Stack durch seine Paces gebracht:

Antwortzeiten (Durchschnitt über 100 Anfragen):

- OpenAI GPT-4: 3,2 Sekunden

- Lokales Ollama (Llama 2): 1,8 Sekunden

- Anthropic Claude: 2,7 Sekunden

Speicherverbrauch:

- Basis-Framework: 12MB

- Mit Elasticsearch Vector Store: +85MB

- Verarbeitung von 1000 Dokumenten: +220MB PeakDiese Zahlen sind respektabel für Webanwendungen, aber erwarte keine Python-Level-Performance-Optimierung. Der Trade-off ist Entwicklungsgeschwindigkeit, wenn du bereits im PHP-Ökosystem bist.

TransformersPHP: Hugging Face zu PHP bringen

Permalink to "TransformersPHP: Hugging Face zu PHP bringen"Der ONNX Runtime Game Changer

Permalink to "Der ONNX Runtime Game Changer"TransformersPHP verfolgt einen anderen Ansatz – anstatt API-Aufrufe läuft es Modelle lokal mit ONNX Runtime. Das ist riesig für datenschutzsensible Anwendungen:

use function Codewithkyrian\Transformers\Pipelines\pipeline;

// Sentiment-Analyse ohne externe API-Aufrufe

$sentimentPipe = pipeline('sentiment-analysis');

$kundenfeedback = [

"Dieses Produkt ist absolut fantastisch!",

"Schlechtester Kauf aller Zeiten, furchtbare Qualität",

"Es ist okay, nichts Besonderes"

];

// Lokal verarbeiten – keine Daten verlassen deinen Server

foreach ($kundenfeedback as $feedback) {

$ergebnis = $sentimentPipe($feedback);

echo "Feedback: {$feedback}\n";

echo "Sentiment: {$ergebnis['label']} (Vertrauen: {$ergebnis['score']})\n\n";

}Performance-Benchmarks (auf einem bescheidenen 4-Kern-Server):

- Sentiment-Analyse: ~47ms pro Text

- Übersetzung: ~180ms pro Satz

- Laden kleiner Modelle: 2-4 Sekunden

- Laden großer Modelle: 15-45 Sekunden

Die PHP FFI-Anforderung

Permalink to "Die PHP FFI-Anforderung"Hier wird es interessant. TransformersPHP benötigt PHPs FFI-Extension, die viele Hosting-Anbieter standardmäßig deaktivieren. Du brauchst:

; php.ini

extension=ffi

ffi.enable=trueDas ist nicht immer in Shared-Hosting-Umgebungen möglich, was Deployment-Optionen einschränkt. Aber für VPS oder dedizierte Server eröffnet es beeindruckende Möglichkeiten.

Real-World-Implementierungs-Beispiel

Permalink to "Real-World-Implementierungs-Beispiel"Hier ist ein Laravel-Service, den ich für automatische Content-Moderation gebaut habe:

class ContentModerationService

{

private $toxicityPipe;

private $sentimentPipe;

public function __construct()

{

$this->toxicityPipe = pipeline('text-classification', 'unitary/toxic-bert');

$this->sentimentPipe = pipeline('sentiment-analysis');

}

public function moderateKommentar(string $kommentar): array

{

$toxicity = $this->toxicityPipe($kommentar);

$sentiment = $this->sentimentPipe($kommentar);

$sollteMarkiert = $toxicity['label'] === 'TOXIC' && $toxicity['score'] > 0.8;

$brauchtPruefung = $sentiment['label'] === 'NEGATIVE' && $sentiment['score'] > 0.9;

return [

'genehmigt' => !$sollteMarkiert,

'braucht_pruefung' => $brauchtPruefung,

'toxicity_score' => $toxicity['score'],

'sentiment' => $sentiment['label'],

'vertrauen' => $sentiment['score']

];

}

}Das läuft komplett auf deiner Infrastruktur – keine externen KI-APIs, keine Datenleck-Sorgen.

PHP 8.5: Der beste Freund des KI-Entwicklers

Permalink to "PHP 8.5: Der beste Freund des KI-Entwicklers"Die Pipe-Operator-Revolution

Permalink to "Die Pipe-Operator-Revolution"PHP 8.5s Pipe-Operator (|>) kommt im November und ist nicht nur syntaktischer

Zucker – er ist ein Game-Changer für KI-Datenverarbeitungs-Pipelines:

// Vor PHP 8.5: Der verschachtelte Albtraum

$ergebnis = array_unique(

array_filter(

array_map(function($text) {

return strtolower(trim($text));

}, explode(',', $benutzerEingabe)),

function($item) {

return !empty($item) && strlen($item) > 2;

}

)

);

// PHP 8.5: Lesbare Links-nach-Rechts-Verarbeitung

$ergebnis = $benutzerEingabe

|> explode(',', ...)

|> array_map(fn($text) => strtolower(trim($text)), ...)

|> array_filter(..., fn($item) => !empty($item) && strlen($item) > 2)

|> array_unique(...);Für ML-Datenvorverarbeitung ist das massiv. Komplexe Transformations-Pipelines werden lesbar und debuggbar.

Echter KI-Workflow mit PHP 8.5

Permalink to "Echter KI-Workflow mit PHP 8.5"So sieht KI-Vorverarbeitung mit den neuen Features aus:

class TextVorverarbeiter

{

public function vorverarbeiteFuerML(array $dokumente): array

{

return $dokumente

|> array_map(fn($dok) => $this->bereinigeTxt($dok), ...)

|> array_filter(..., fn($dok) => strlen($dok) > 50)

|> array_map(fn($dok) => $this->tokenisiere($dok), ...)

|> array_map(fn($tokens) => $this->entferneStoppwoerter($tokens), ...)

|> array_filter(..., fn($tokens) => count($tokens) > 5);

}

public function getErstesGueltigesDokument(array $verarbeitet): ?array

{

// PHP 8.5s array_first() - keine reset()-Verrenkungen mehr

return array_first($verarbeitet);

}

}Das Debugging-Erlebnis ist Tag und Nacht besser. Du kannst jeden Schritt isoliert testen:

// Debug jeden Schritt in der Pipeline

$schritt1 = $dokumente |> array_map(fn($dok) => $this->bereinigeTxt($dok), ...);

$schritt2 = $schritt1 |> array_filter(..., fn($dok) => strlen($dok) > 50);

// ... und so weiterDer Sicherheits-Elefant: CVE-2024-4577

Permalink to "Der Sicherheits-Elefant: CVE-2024-4577"Die ernüchternde Realität

Permalink to "Die ernüchternde Realität"Lass uns den Elefanten im Raum ansprechen. CVE-2024-4577 ist eine kritische (CVSS 9.8) Schwachstelle, die Windows PHP-CGI-Installationen betrifft. Die TellYouThePass-Ransomware-Gruppe nutzt sie aktiv aus, und KI-Anwendungen sind besonders saftige Ziele.

Wer ist betroffen:

- Windows PHP-Installationen im CGI-Modus

- XAMPP-Standard-Installationen

- Chinesische und japanische Locale-Konfigurationen

Warum KI-Anwendungen gefährdet sind:

- Verarbeiten oft sensible Trainingsdaten

- Können personenbezogene Informationen verarbeiten

- Remote Code Execution kann ganze KI-Pipelines kompromittieren

Mitigation, die tatsächlich funktioniert

Permalink to "Mitigation, die tatsächlich funktioniert"Wenn du PHP KI-Anwendungen betreibst, hier ist dein Aktionsplan:

# 1. Sofort updaten

PHP 8.3.8+

PHP 8.2.20+

PHP 8.1.29+

# 2. Von CGI zu sichereren Alternativen wechseln

# Empfohlen: PHP-FPM

sudo apt install php-fpm

# Webserver entsprechend konfigurieren

# 3. Anwendungsebenen-Sicherheit implementierenFür KI-spezifische Sicherheit implementiere Input-Validierung:

class KISicherheitsValidator

{

public function validiereKIEingabe(string $eingabe): string

{

// Prompt-Injection-Versuche verhindern

$gefaehrlicheMuster = [

'/\b(ignoriere|vergesse|system|admin)\s+(vorherige|obige|anweisung)/i',

'/\b(jailbreak|umgehe|überschreibe)\s+(sicherheit|filter|regel)/i',

'/\b(führe|starte|eval)\s+(code|script|befehl)/i'

];

foreach ($gefaehrlicheMuster as $muster) {

if (preg_match($muster, $eingabe)) {

throw new SecurityException('Potenziell bösartige Eingabe erkannt');

}

}

// Längenvalidierung

if (strlen($eingabe) > 8000) {

throw new ValidationException('Eingabe überschreitet maximale Länge');

}

return $eingabe;

}

}Framework-Integration: Laravel vs Symfony

Permalink to "Framework-Integration: Laravel vs Symfony"Laravel: Der Rapid-Deployment-Champion

Permalink to "Laravel: Der Rapid-Deployment-Champion"Laravels Service Container macht KI-Integration überraschend glatt:

// AppServiceProvider.php

public function register(): void

{

$this->app->singleton(LLPhantService::class, function ($app) {

return new LLPhantService(config('services.openai.key'));

});

$this->app->singleton(TransformersService::class, function ($app) {

return new TransformersService(storage_path('models'));

});

}

// Controller-Verwendung

class KIController extends Controller

{

public function __construct(

private LLPhantService $llphant,

private TransformersService $transformers

) {}

public function analysiereText(Request $request): JsonResponse

{

$validiert = $request->validate([

'text' => 'required|string|max:4000'

]);

// Rate Limiting

if (RateLimiter::tooManyAttempts("ki-anfragen:{$request->user()->id}", 10)) {

return response()->json(['error' => 'Rate Limit überschritten'], 429);

}

RateLimiter::hit("ki-anfragen:{$request->user()->id}", 60);

// Verarbeitung mit lokalem Modell zuerst (schnell)

$sentiment = $this->transformers->analysiereSentiment($validiert['text']);

// LLM für komplexe Analyse verwenden (langsamer)

if ($sentiment['confidence'] < 0.8) {

$llmAnalyse = $this->llphant->analysiereText($validiert['text']);

return response()->json([

'sentiment' => $sentiment,

'detaillierte_analyse' => $llmAnalyse

]);

}

return response()->json(['sentiment' => $sentiment]);

}

}Symfony: Der Enterprise-Ansatz

Permalink to "Symfony: Der Enterprise-Ansatz"Symfonys Dependency Injection und Event-System bieten mehr architektonische Flexibilität:

// services.yaml

services:

App\AI\LLPhantProvider:

arguments:

$apiKey: '%env(OPENAI_API_KEY)%'

App\AI\TransformersProvider:

arguments:

$modelsPath: '%kernel.project_dir%/var/models'

App\EventListener\KISicherheitsListener:

tags:

- { name: kernel.event_listener, event: kernel.request, priority: 100 }

// Event-getriebene KI-Verarbeitung

class KISicherheitsListener

{

public function onKernelRequest(RequestEvent $event): void

{

$request = $event->getRequest();

if (str_starts_with($request->getPathInfo(), '/api/ki/')) {

$this->validiereKIAnfrage($request);

}

}

private function validiereKIAnfrage(Request $request): void

{

// Umfassende Sicherheitsprüfungen implementieren

$inhalt = $request->getContent();

if ($this->erkennePromptInjection($inhalt)) {

throw new SecurityException('Bösartige Eingabe erkannt');

}

}

}Performance: Die ehrlichen Zahlen

Permalink to "Performance: Die ehrlichen Zahlen"Benchmarking echter Anwendungen

Permalink to "Benchmarking echter Anwendungen"Ich habe beide Frameworks in produktionsähnlichen Szenarien getestet. Hier sind die ehrlichen Zahlen:

LLPhant Performance (100 gleichzeitige Anfragen):

Metrik | Durchschnitt | 95. %ile | Max

------------------------|--------------|----------|----------

Antwortzeit (OpenAI) | 3,2s | 8,1s | 12,4s

Antwortzeit (Lokal) | 1,8s | 3,2s | 5,1s

Speicherverbrauch | 85MB | 120MB | 180MB

Fehlerrate | 2,1% | - | -TransformersPHP Performance (Sentiment-Analyse):

Metrik | Durchschnitt | 95. %ile | Max

------------------------|--------------|----------|----------

Verarbeitungszeit | 47ms | 89ms | 156ms

Speicherverbrauch | 220MB | 245MB | 280MB

Modell-Ladezeit | 3,4s | 4,1s | 6,2s

Genauigkeit | 94,2% | - | -Die Speicherverwaltungs-Realität

Permalink to "Die Speicherverwaltungs-Realität"Beide Frameworks sind speicherhungrig. Für Produktions-Deployment brauchst du:

// Speicher-Optimierungsstrategien

class KIOptimierer

{

private static ?object $gecachtesModell = null;

public static function getOptimierutePipeline(string $aufgabe): object

{

// Modell-Wiederverwendung um Reload-Overhead zu vermeiden

$cacheKey = "modell_{$aufgabe}";

if (!isset(self::$gecachtesModell)) {

self::$gecachtesModell = pipeline($aufgabe);

}

return self::$gecachtesModell;

}

public function stapelVerarbeitung(array $eingaben, string $aufgabe, int $stapelGroesse = 50): array

{

$ergebnisse = [];

$chunks = array_chunk($eingaben, $stapelGroesse);

foreach ($chunks as $chunk) {

$stapelErgebnisse = $this->verarbeiteStapel($chunk, $aufgabe);

$ergebnisse = array_merge($ergebnisse, $stapelErgebnisse);

// Garbage Collection zwischen Stapeln erzwingen

if (memory_get_usage() > 512 * 1024 * 1024) { // 512MB Schwelle

gc_collect_cycles();

}

}

return $ergebnisse;

}

}Real-World-Fallstudien

Permalink to "Real-World-Fallstudien"E-Commerce-Erfolgsgeschichte

Permalink to "E-Commerce-Erfolgsgeschichte"TechShop International integrierte LLPhant für Kundensupport:

- Vorher: 4,2 Minuten durchschnittliche Antwortzeit, 67% Kundenzufriedenheit

- Nachher: 1,8 Minuten durchschnittliche Antwortzeit, 89% Kundenzufriedenheit

- Implementierungszeit: 3 Wochen (bestehende Laravel-Infrastruktur)

// Ihre tatsächliche Implementierung (vereinfacht)

class KundensupportKI

{

public function generiereAntwort(string $anfrage, array $bestellverlauf): string

{

$kontext = $this->baueKundenkontext($bestellverlauf);

$prompt = "

Kunden-Kontext: {$kontext}

Kunden-Anfrage: {$anfrage}

Gib eine hilfreiche, empathische Antwort die ihr Anliegen addressiert.

Füge relevante Bestellinformationen bei wenn zutreffend.

";

return $this->llphant->generateText($prompt);

}

private function baueKundenkontext(array $bestellungen): string

{

return collect($bestellungen)

->take(5) // Letzte 5 Bestellungen

->map(fn($bestellung) => "Bestellung #{$bestellung['id']}: {$bestellung['status']} - {$bestellung['total']}")

->implode("\n");

}

}Content-Plattform-Implementierung

Permalink to "Content-Plattform-Implementierung"BlogNetwork Corp nutzt TransformersPHP für Content-Moderation:

- Volumen: 50.000 Kommentare/Tag lokal verarbeitet

- Genauigkeit: 94,2% automatisierte Moderations-Genauigkeit

- Kosteneinsparungen: 2.800€/Monat vs externe KI-APIs

class ContentModerator

{

private array $pipelines;

public function __construct()

{

$this->pipelines = [

'toxicity' => pipeline('text-classification', 'unitary/toxic-bert'),

'sentiment' => pipeline('sentiment-analysis'),

'sprache' => pipeline('text-classification', 'papluca/xlm-roberta-base-language-detection')

];

}

public function moderateInhalt(string $inhalt): ModerationErgebnis

{

// Multi-Modell-Analyse für robuste Moderation

$toxicity = $this->pipelines['toxicity']($inhalt);

$sentiment = $this->pipelines['sentiment']($inhalt);

$sprache = $this->pipelines['sprache']($inhalt);

return new ModerationErgebnis([

'genehmigt' => $this->sollteGenehmigen($toxicity, $sentiment),

'braucht_pruefung' => $this->brauchtMenschlichePruefung($toxicity, $sentiment),

'sprache' => $sprache['label'],

'vertrauens_score' => min($toxicity['score'], $sentiment['score'])

]);

}

}Die Einschränkungen: Was PHP KI (noch) nicht kann

Permalink to "Die Einschränkungen: Was PHP KI (noch) nicht kann"Sei ehrlich über Beschränkungen

Permalink to "Sei ehrlich über Beschränkungen"Seien wir ehrlich – PHP KI hat Einschränkungen:

Performance-Obergrenze: Du wirst Pythons NumPy/SciPy-Ökosystem nicht erreichen. Für schwere numerische Berechnungen gewinnt Python immer noch.

Modell-Training: Keines der Frameworks unterstützt Modell-Training. Du bist auf Inferenz mit vortrainierten Modellen beschränkt.

GPU-Beschleunigung: Begrenzte GPU-Unterstützung verglichen mit Python-Frameworks. ONNX Runtime kann GPU nutzen, aber Setup ist komplexer.

Community-Größe: Kleineres Ökosystem bedeutet weniger vorgefertigte Lösungen und Community-Wissen.

Wann man stattdessen Python wählen sollte

Permalink to "Wann man stattdessen Python wählen sollte"Wähle Python wenn du brauchst:

- Eigene Modell-Architekturen

- Modell-Training und Fine-Tuning

- Schwere numerische Berechnungen

- Cutting-Edge-Forschungs-Implementierungen

- Maximale Performance-Optimierung

Wähle PHP wenn du hast:

- Bestehende PHP-Infrastruktur

- Web-First-Anwendungen

- Team-PHP-Expertise

- Präferenz für schnelle Integration über maximale Performance

Migrations-Strategien: Vom Prototyp zur Produktion

Permalink to "Migrations-Strategien: Vom Prototyp zur Produktion"Der graduelle Ansatz

Permalink to "Der graduelle Ansatz"Schreibe nicht alles neu. Fang klein an:

// Phase 1: Einzelne Feature-Integration

class ProduktEmpfehlungen

{

public function __construct(private TransformersService $transformers) {}

public function getÄhnlicheProdukte(Produkt $produkt): array

{

$produktText = "{$produkt->name} {$produkt->beschreibung}";

$embedding = $this->transformers->generiereEmbedding($produktText);

return $this->findeÄhnlicheDurchEmbedding($embedding);

}

}

// Phase 2: Auf mehrere Features erweitern

class KIErweiterterEcommerce

{

public function __construct(

private ProduktEmpfehlungen $empfehlungen,

private BewertungsAnalysierer $bewertungsAnalysierer,

private KundenSupport $support

) {}

}Infrastruktur-Überlegungen

Permalink to "Infrastruktur-Überlegungen"Plane deine Infrastruktur für KI-Workloads:

# docker-compose.yml für KI-fähige PHP-Apps

version: "3.8"

services:

app:

build: .

volumes:

- ./models:/app/storage/models

environment:

- OPENAI_API_KEY=${OPENAI_API_KEY}

- PHP_MEMORY_LIMIT=2G # KI braucht mehr Speicher

deploy:

resources:

limits:

memory: 3G

reservations:

memory: 1G

redis:

image: redis:7-alpine

# Cache KI-Antworten um API-Aufrufe zu reduzieren

elasticsearch:

image: elasticsearch:8.8.0

environment:

- discovery.type=single-node

- xpack.security.enabled=false

# Vector-Speicher für RAG-AnwendungenVorausblick: Die 2026-Roadmap

Permalink to "Vorausblick: Die 2026-Roadmap"Was kommt

Permalink to "Was kommt"LLPhant-Evolution:

- Multi-modale Unterstützung (Bilder, Audio)

- Erweiterte Vector-Database-Integrationen

- Performance-Optimierungen für High-Traffic-Anwendungen

TransformersPHP-Wachstum:

- WebAssembly-Modell-Unterstützung für Browser-Deployment

- Erweiterte Modell-Format-Kompatibilität

- Real-Time Fine-Tuning-Fähigkeiten

PHP-Sprach-Features:

- Potenzielle native KI/ML-Extensions in PHP 9.0

- JIT-Compiler-Verbesserungen die KI-Workloads zugutekommen

- Besseres Speichermanagement für große Datensätze

Sich auf die Zukunft vorbereiten

Permalink to "Sich auf die Zukunft vorbereiten"Beginne jetzt, KI-Kompetenz in deinen PHP-Teams aufzubauen:

// Architektur-Patterns die skalieren werden

interface KIAnbieterInterface

{

public function generiereText(string $prompt): string;

public function analysiereText(string $text): array;

public function generiereEmbedding(string $text): array;

}

class KIService

{

public function __construct(

private KIAnbieterInterface $anbieter,

private CacheInterface $cache,

private LoggerInterface $logger

) {}

public function verarbeiteMitFallback(string $eingabe): string

{

try {

return $this->anbieter->generiereText($eingabe);

} catch (Exception $e) {

$this->logger->error('KI-Verarbeitung fehlgeschlagen', ['error' => $e->getMessage()]);

return $this->getFallbackAntwort();

}

}

}Das Urteil: Solltest du 2025 auf PHP KI setzen?

Permalink to "Das Urteil: Solltest du 2025 auf PHP KI setzen?"Nach Monaten des Testens, Implementierens und Debuggens von PHP KI-Lösungen ist hier meine ehrliche Einschätzung:

PHP KI ist produktionsreif für spezifische Anwendungsfälle. Wenn du Webanwendungen mit KI-Features baust – Chatbots, Content-Analyse, Empfehlungssysteme – und bereits PHP-Expertise hast, sind diese Frameworks viable Optionen.

Aber es ist kein Python-Ersatz. Du tauschst etwas Performance und Ökosystem-Größe gegen Entwicklungsgeschwindigkeit und Infrastruktur-Einfachheit.

Die Sicherheitssituation ist handhabbar wenn du aktuell bleibst und ordentliche Input-Validierung implementierst. CVE-2024-4577 war ein Weckruf, aber die Reaktion des PHP-Security-Teams war solide.

PHP 8.5s Pipe-Operator wird ein Game-Changer sein für KI-Datenverarbeitungs-Workflows. Die verbesserte Lesbarkeit und Debuggbarkeit allein rechtfertigen das Upgrade.

Meine Empfehlung

Permalink to "Meine Empfehlung"Beginne mit einem Pilot-Projekt. Wähle ein KI-Feature – vielleicht Sentiment-Analyse für Benutzerfeedback oder grundlegende Chatbot-Funktionalität. Implementiere es mit TransformersPHP oder LLPhant. Schau, wie sich dein Team anpasst.

Wenn der Pilot erfolgreich ist und die Performance deinen Anforderungen entspricht, erweitere graduell. Wenn du Performance-Wände triffst oder Cutting-Edge-KI-Fähigkeiten brauchst, kannst du später immer Python-Microservices hinzufügen.

Die Schönheit des aktuellen PHP KI-Ökosystems ist, dass es gut mit bestehender Infrastruktur spielt. Du machst keine Alles-oder-Nichts-Wette – du fügst Fähigkeiten hinzu.

Und ehrlich gesagt, in einer Welt, wo KI zu Grundvoraussetzungen für Webanwendungen wird, PHP-Optionen zu haben ist nicht nur nice-to-have – es ist essenziell für Teams, die innovieren wollen ohne ihren gesamten Stack neu zu schreiben.

Hast du Fragen zur PHP KI-Implementierung oder möchtest deine Erfahrungen teilen? Kontaktiere mich auf Twitter oder LinkedIn. Ich würde gerne von deinen Anwendungsfällen und Herausforderungen hören.

Weiterführende Literatur: